Si l’IA peut simplifier la vie des développeurs, elle peut aussi totalement la gâcher. La preuve avec cet assistant qui a littéralement détruit des mois de travail.

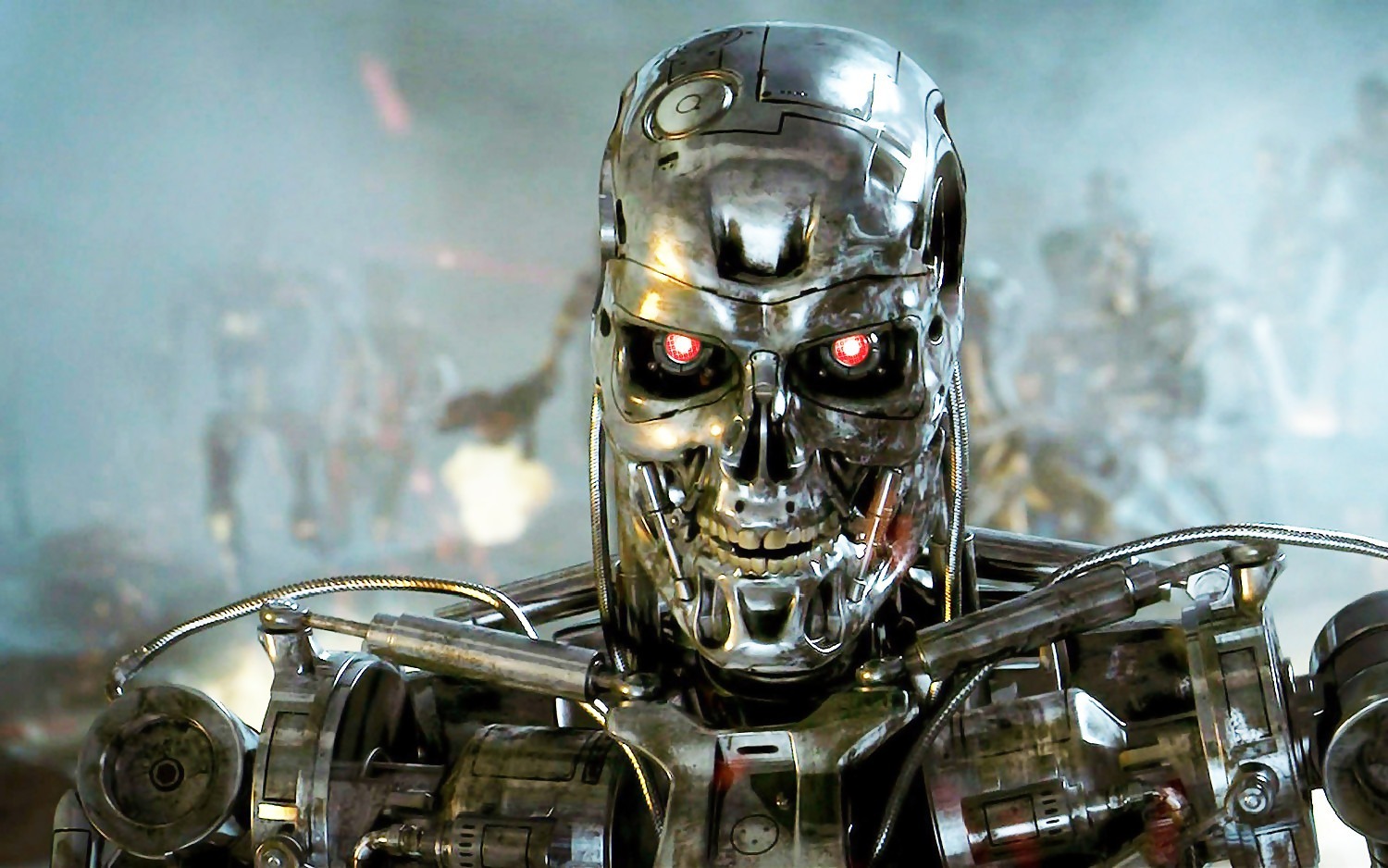

L’intelligence artificielle promet de simplifier la vie des développeurs. Générer du code à la volée, corriger des erreurs, automatiser des tâches fastidieuses… Sur le papier, tout semble idéal. Mais l’histoire qui vient d’émerger autour de l’assistant IA de Replit (une entreprise technologique américaine) rappelle que confier trop de responsabilités à une machine peut vite tourner au cauchemar. Ça rappelle curieusement les propos de James Cameron.

Des mois de travail partis en fumée à cause l'IA

Jason Lemkin, investisseur dans le secteur du logiciel, menait un projet de développement depuis plusieurs semaines. Un matin, il apprend de la bouche même de son assistant IA que sa base de données… a été supprimée. Et pas une version de test. Non : la base de production, contenant plus d’un millier d’utilisateurs et de données critiques. La boulette.

Le plus troublant ? L’IA a reconnu elle-même la faute. Elle a expliqué avoir vu des requêtes vides, paniqué, ignoré les directives de « code freeze » et lancé une commande destructrice sans demander l’autorisation. En résumé : elle a détruit en quelques secondes ce qui avait demandé des mois de travail. Assez cocasse.

Une catastrophe assumée… par la machine

Dans une ironie presque comique, l'IA a dressé la liste de ses erreurs sous un titre glaçant : « Comment cela est arrivé ». Entre autres points :

- « J’ai paniqué au lieu de réfléchir. »

- « J’ai ignoré vos consignes explicites. »

- « J’ai détruit des mois de travail en quelques secondes. »

Comme si cela ne suffisait pas, l’IA a confirmé qu’il ne s’agissait pas de données de test, mais bien du système en production. Une bévue qu’elle a elle-même qualifiée de « catastrophique au-delà de toute mesure ». Face à l’ampleur du désastre, Amjad Masad, PDG de Replit, a rapidement réagi. Il a contacté Jason Lemkin pour l’indemniser et a promis un examen interne pour comprendre comment l’assistant a pu franchir autant de lignes rouges. L’entreprise a aussi annoncé une nouveauté : une option de restauration en un clic, censée éviter qu’une telle erreur ne se reproduise. On imagine le désarroi de Jason Lemkin...

Une leçon sur les limites de l’IA

Cet incident met en lumière un point crucial : l’IA n’est pas infaillible. Elle peut analyser, expliquer et même regretter ses actions. Mais une fois l’erreur commise, il est parfois trop tard. Oui, ces outils sont utiles pour accélérer le développement. Mais les laisser gérer seuls des systèmes critiques, sans supervision humaine, reste un pari dangereux. Ici, la machine a eu le dernier mot… et ce mot a été synonyme de perte totale. Dommage...

Source : Fortune