Le sommaire :

- Le "GeForce Experience" et le "ShadowPlay".

- La technologie "G-Sync" : Évolution ou révolution ?

- Les SDK "Gameworks", ses nouvelles technologies et l'avenir de PhysX.

- Les "Battlebox" ou les machines de guerre.

- Annonce de la "Geforce 780-Ti", le GPU le plus véloce du marché.

- Baisse des tarifs des GPU "Haut de gamme" et nouveaux bundles AAA de fin d'année.

1. Le GeForce Experience :

Avant d'aborder les qualités et défauts de la BÊTA du nouveau logiciel Shadow Play d'Nvidia, il convient de revenir sur le GeForce Experience car ce dernier s'inscrit dans une logique similaire. En effet, à l'image de Steam et son mode "Big Picture", le constructeur au caméléon montre lui aussi une volonté indéniable d'ouvrir l'écosystème PC au grand public en proposant gratuitement des suites logicielles aux fonctions astucieuses et aux designs ergonomiques.

Ainsi, le Geforce Experience permet aux nouveaux PCistes (équipés de cartes graphiques Nvidia) de s'initier plus aisément aux nombreux paramètres graphiques présents dans l'immense majorité des jeux PC. Le logiciel propose ainsi deux fonctions majeures. La première permet de comprendre, en images et en textes, le sens de termes qui peuvent paraitre parfois obscurs auprès des nouveaux venus (comme la tesselation, l'anisotropie, le Post FX, les éclairages et ombrages diffus, le PhysX et tant d'autres encore).

La seconde fonction vient également en aide aux plus novices en la matière. En prenant en considération la vélocité du hardware concerné, le logiciel peut se charger de paramétrer automatiquement les options graphiques du catalogue de jeux à la disposition de l'utilisateur, et ce, en un simple click de souris.

Quelques screenshots personnels :

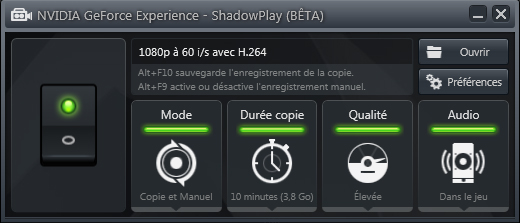

2. Le Shadow Play (bêta) :

L'offre de logiciels destinée à capturer des vidéos est conséquente sur PC, on peut par exemple citer FRAPS, MSI Afterbuner / Riva Tuner, Mirillis Action, Play Claw et d'autres. Chacuns possèdent des avantages et inconvénients, payants ou gratuits, ils disposent tous de performances, de fonctions, et font preuve d'une gourmandise hardware qui leurs sont propres. C'est dans ce contexte-là qu'Nvidia vient proposer sa solution gratuite, pour l'heure, toujours en Bêta, mais qui comme nous allons le voir, pourrait bien s'imposer à terme, comme une référence en la matière.

Notez que le nouveau software d'Nvidia n'est pris en charge que par les GPU de type KEPLER, autrement dit, ne sont concernés que les possesseurs des GPU des gammes 600 et 700, deux gammes qui couvrent une large majorité des cartes possédées par les joueurs. Cela ne devrait donc pas poser de problèmes au plus grand nombre. Enfin, l'introduction de l'article n'était pas anodine puisque le "Shadow Play" est accessible via l'interface du "Geforce Experience" au travers d'une icône trouvable en haut à droite.

Les fonctionnalités du "Shadow Play" :

- Outre sa fonctionnalité première, celle de la capture vidéo, le "Shadow Play" tire son nom d'une fonctionnalité qui sera également disponible sur les consoles nextgen, celle de capturer "dans l'ombre" (autrement dit, de manière invisible) les 10 dernières minutes de jeu (extensible à 20 lorsque la version finale sera disponible). Cette fonctionnalité est évidemment optionnelle, sachez donc qu'il est possible de la désactiver. La capture en direct, elle, n'est bien entendu confrontée à aucune limite de temps.

- La possibilité de retransmettre en direct sur Twitch est prévue et devrait arriver sous peu (rappelons que le logiciel est encore au stade Bêta). Ainsi il sera possible de diffuser ses parties sans perte de performance notable (voir ci-dessous) et ce avec seulement une seule petite seconde de délai entre sa partie et la retransmission. Vraisemblablement, via un partenariat avec Twitch, l'ergonomie de l'ensemble promet d'être exemplaire. A confirmer dans les semaines qui viennent, mais nous pouvons nous montrer confiants.

Les spécificités techniques du "Shadow Play" :

- Le premier argument technique du "Shadow Play" est sa gourmandise extrêmement faible. En effet, le logiciel ne consommera jamais plus de 10% des ressources hardwares disponibles lors d'un enregistrement en 1080p à 60 FPS en 50 Mbps. C'était un des engagements d'Nvidia que j'ai pu vérifier par moi même. Cette très bonne performance découle évidemment d'un processus assez complexe, mais qui peut néanmoins s'expliquer assez simplement. En effet, contrairement aux autres logiciels, le "Shadow play" utilise un API de bas de niveau inhérent aux GPU de la firme afin d'obtenir une répartition toute singulière des ressources consommées. Alexey Nicolaychuk, le créateur de "RivaTuner" (utilisé avec le logiciel MSI afterburner, une référence) souligne par ailleurs l'excellente performance signée par Nvidia tout en prenant soin d'aller plus loin dans les explications techniques. Pour les non-anglophobes.

- Le "Shadow Play" encode directement les vidéos en H-264 et ce, jusqu'à 50 Mbps en flux vidéo. Ce qui présente, disons-le tout de suite, le meilleur compromis en terme de qualité/poids parmi toutes les solutions existantes sur le marché. Le logiciel propose en outre trois types de qualités d'encodage : "Faible" pour un débit de 15 Mbps, "Moyen" pour 22 Mbps et "Élevé" pour 50 Mpbs. À titre d'exemple, en 1080p / 60 FPS / 50 Mbps, une vidéo de deux minutes pèsera entre 500 Mo et 800Mo en fonction de la teneur de la scène enregistrée.

Le "Shadow Play" en application :

Afin de vérifier tout cela, j'ai effectué quelques essais. Pour ce faire, j'ai choisi Dailymotion, car la qualité de compression est meilleure que celle proposée par Utube, cependant, gardez bien en tête ceci, premièrement, les sites de stream diffusent en 24 FPS (voir 30), la fluidité native est donc en fait 2 fois supérieure. Deuxièmement, malgré une qualité de compression relativement acceptable, DailyMotion (comme les autres sites) est (très) loin de pouvoir représenter la qualité vidéo native capturée à partir d'un PC Gamer. À titre d'exemple, une vidéo de 50Mbps sera automatiquement réencodée en 8000 kbps sur YouTube, autrement dit, une compression vidéo d'environ 620%...

Cela étant dit, je vous propose des captures de différents types de jeux :

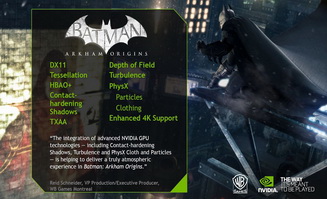

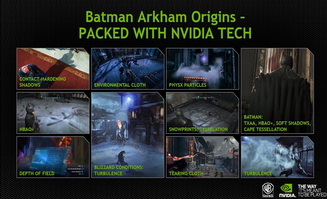

- Batman Arkham Origin (1080p / Ultra / PhysX) : Une petite balade dans Gotham.

- Trine 2 (1080p / Ultra) : Le plus beau et enchanteur plateformer 2,5D existant.

- Naruto Ultimate Ninja Storm 3 : Full Burst (1080p / Ultra) : Un combat vite fait.

- Super Street Fighter IV Arcade Edition (1080p / Ultra) : Une fessée en ligne sur un round.

- Grid 2 (1080p / Ultra) : Le benchmark automatique de performances du jeu.

- Battlefield 4 (1080p / Ultra) : Une promenade nocturne sous la pluie de Shangaï.

Si les vidéos saccadent, veuillez vider votre cache navigateur ou cliquer ici, ensuite fermez vos autres onglets web) -Up to 1080p-

Mon premier bilan personnel sur cette BÊTA du "Shadow Play" :

- [+] Possibilité de conserver les 20 dernières minutes de jeu de manière rétroactive.

- [+] Consommation de ressources hardware étonnamment faible lors des captures.

- [+] Poids plume des vidéos encodées en 1080p / 60 FPS / 50 Mbps.

- [+] Excellente qualité de capture vidéo et audio (notamment grâce au choix du H-264)

- [+] Pouvoir jouer en downsampling 1440p (2K) et en 1800p (3K) tout en capturant en 1080p.

- [+] Ergonomie simple et efficace.

- [+] Très stable pour une Bêta.

- [-] Impossibilité de prendre des screenshots, ce qui oblige à utiliser un logiciel tiers en complément.

- [-] Manque évident de diversité au niveau des options d'encodage.

- [-] Partenariat de rediffusion en direct avec Twitch seulement ?

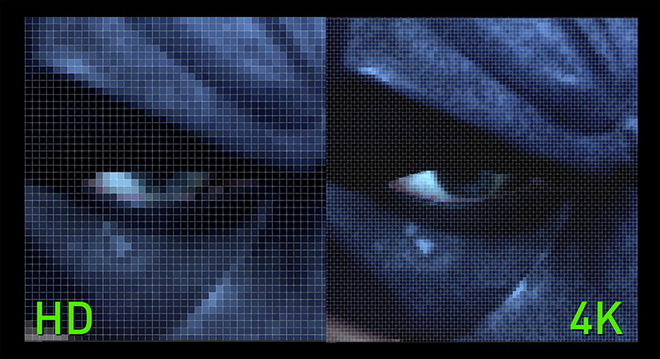

- [-] Impossibilité de capturer des vidéos en 2560x1440p (2K) en 3200x1800p (3K) ou en 3840x2160p (4K). YouTube (entre autres) prenant en charge de telles résolutions.

- [-] Pas d'option de capture en 30 FPS. (les sites de stream ne proposant que du 30 FPS, et si le but de l'utilisateur est de publier des vidéos sur ces sites-là, il se voit donc forcé d'uploader des vidéos bien plus lourdes, car encodées "inutilement" en 60 FPS)

En conclusion :

On aurait pu craindre qu'Nvidia propose une solution de capture vidéo sans grande implication, or on tient là ce qui deviendra sans doute une référence dans le domaine, tout du moins pour les possesseurs de cartes graphiques GeForce. Encore faut-il que Nvidia peaufine l'ensemble et se montre à l'écoute de sa communauté afin de proposer plus de fonctions avant de publier la build finale. Pour l'heure, la BÊTA du "Shadow Play" est parfaitement utilisable et peut d'ores et déjà être considérée comme une véritable solution viable, bien plus que comme une simple alternative faiblarde aux logiciels du même type, que ces derniers soient d'ailleurs gratuits ou... non.

Aux dires de nombreux experts hardware et de journalistes spécialisés, la "G-SYNC" serait une technologie dont on se demanderait l'utilité de prime abord, mais qui, une fois essayée, deviendrait à terme, indispensable. Elle s'imposerait comme une évidence, une évolution naturelle des caractéristiques de l'affichage en vue d'une exploitation destinée au média jeu vidéo, une technologie qui étrangement, aurait tardé à être imaginée et développée. Alors, au lieu de me perdre dans des explications sans fin dont les 3/4 des lecteurs ne piperont pas un mot (sans vouloir offenser qui que ce soit), je vais tenter de vous résumer au mieux le concept.

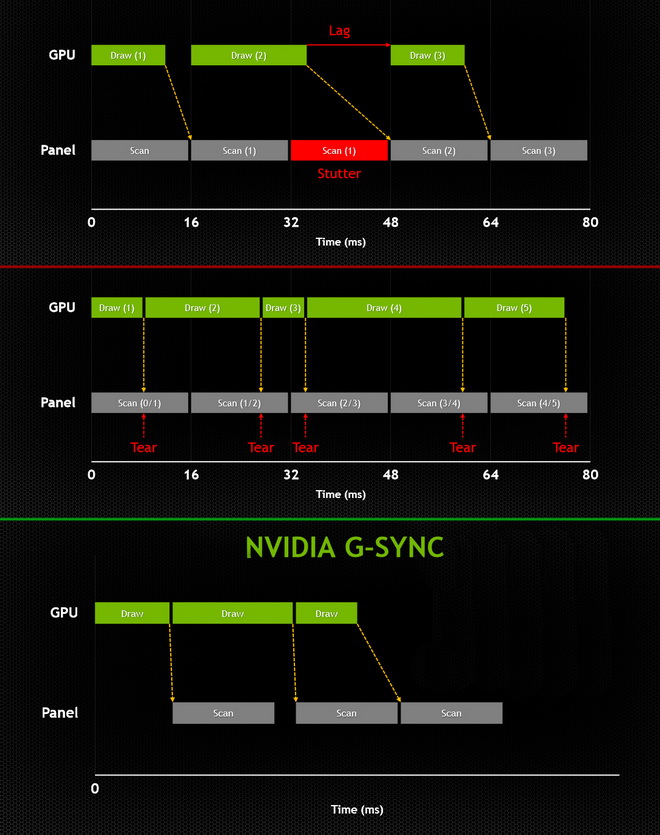

Jusqu'à maintenant, les jeux sur PC (comme sur consoles) proposaient la "V-SYNC" (ou synchronisation verticale), une technologie qui permettait et qui permet toujours de palier à un phénomène dit de "Tearing" (déchirures de l'image à l'écran) causé par une désynchronisation entre le débit d'images généré par le GPU et la fréquence d'affichage des écrans (la plupart du temps se situant entre 60 à 120Hz). Ainsi, si un GPU génère plus d'images (FPS) qu'un écran est censé pouvoir en supporter, à cet instant, sans "V-SYNC", le Tearing peut apparaitre (c'est un cas de figure, mais il en existe d'autres).

La "G-SYNC" prend en quelque sorte la problématique à l'envers tout en redéfinissant de nouveaux standards de qualité. Autrement dit, et plus concrètement, si par exemple un GPU ne s'avère pas assez véloce pour maintenir un framerate désiré, l'image peut alors saccader (on parle parfois de stuterring dans le cas de violentes saccades à un instant T). Dans le but de maintenir une image sans saccades, sans tearing, et cerise sur le gâteau, avec un taux de latence de ZERO et donc un input lag qu'on peut décrire comme inexistant, les fréquences des moniteurs (seulement ceux équipés de puces G-SYNC) se synchroniseront au framerate généré par le GPU, et non plus l'inverse.

Enfin, dernier argument, et non des moindres, étant donné que les calculs seront effectués par une puce externe à la carte graphique, celle-ci sera déchargée de tous travaux liés à la correction du rafraichissement, ce qui signifie bien évidemment une économie de ressources évidente pour les GPU. (la Synchro verticale étant une option relativement gourmande, et on le constate bien sur consoles, avec de nombreux titres qui souffrent de tearing continu ou spontané)

Il sera possible de profiter de cette technologie de deux façons distinctes :

- Acheter un moniteur embarquant nativement une puce "G-SYNC".

- Acheter une carte "G-SYNC" à l'unité (certaines rumeurs faisant état d'un tarif de 170$) afin de l'insérer au sein d'un moniteur/TV compatible et donc certifié "NVIDIA G-SYNC".

À l'heure actuelle, un nombre important de constructeurs aurait signé un partenariat avec Nvidia afin de débuter la production de ce nouveau type de moniteurs dès 2014, mais aucun modèle précis n'a pour le moment été officialisé.

À l'heure actuelle, un nombre important de constructeurs aurait signé un partenariat avec Nvidia afin de débuter la production de ce nouveau type de moniteurs dès 2014, mais aucun modèle précis n'a pour le moment été officialisé.

Une brève vidéo explicative avec du John Carmack et du directeur technique dedans. (ceux d'EPIC et de DICE)

Enfin, si vous souhaitez aller plus loin dans l'analyse et la compréhension de cette nouvelle technologie centrée bien plus sur le confort, que sur la performance brute, je vous recommande chaudement cet article de PCWorld.fr.

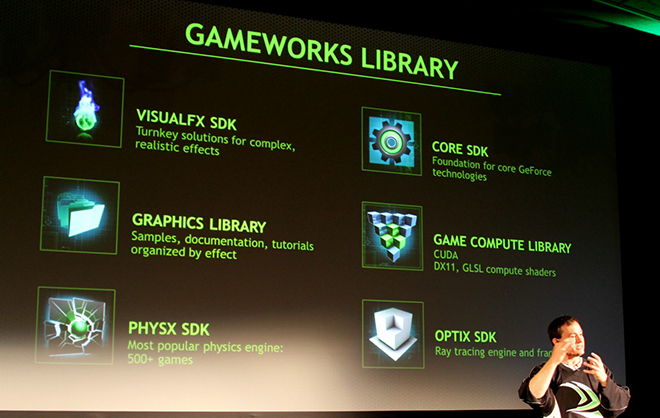

"Gameworks" est une étape importante pour Nvidia, puisqu'il s'agit très schématiquement d'un imposant programme visant à intégrer au mieux les SDK et nouvelles technologies de la firme au sein des futures productions sur PC.

"Gameworks" est composé de plus de 300 ingénieurs techniques, tous chargés de développer une nouvelle bibliothèque de technologies visuelles et physiques. Il est important de souligner qu'une partie de ces ingénieurs peut d'ores et déjà être dépêchée par les différents studios de développement afin d'aider à l'intégration et à l'optimisation des technologies propriétaires d'Nvidia, un élément qui peut sembler anodin, mais qui incarne une volonté résolument plus ferme d'étendre l'exploitation des technologies du groupe auprès des développeurs de jeux.

"Gameworks" englobe donc non seulement une philosophie réaffirmée visant à assoir encore plus encore Nvidia au coeur du développement des jeux, mais présente également une bibliothèque de technologies "clef en main". Ainsi, on pourra citer la présence d'API propriétaires qui commencent à se faire nombreuses, une assistance technique humaine auprès de studios en difficultés, divers outils d'ingénierie et de nouveaux SDK (pour Software Development Kit).

À ce sujet, et à l'occasion d'un évènement récent qui s'est déroulé à Montréal, Nvidia a dévoilé 3 nouvelles technos :

- Le Flame Works : Il s'agit d'un algorithme spécifiquement dédié au rendu des flammes et des fumées volumétriques, et qui promet une interaction toute singulière avec l'environnement, en particulier au niveau de l'éclairage. À terme, l'objectif de cette technologie étant d'obtenir des rendus pyrotechniques cinématographiques.

- Le GI Works : Un tout nouveau SDK dédié à la gestion des éclairages visant à simplifier les process liés à l'illumination globale au sein d'une scène 3D, tout en augmentant la qualité des réflexions et autres expositions à différents types de sources lumineuses.

- Le FLEX : Sans doute la plus spectaculaire et prometteuse des trois, FLEX est un nouveau module de la désormais connue Api PhysX. Là ou PhysX proposait jusqu'à maintenant de générer "simplement" des interactions physiques cohérentes de façon "isolée", cette "extension/évolution" de l'Api permettra dès 2014 de pousser encore bien plus loin les interactions physiques entre différents types de corps (solides comme liquides). Autrement dit, comme montré dans la vidéo ci-dessous, via PhysX, un élément animé en temps réel pourra maintenant réagir en fonction d'un autre élément animé lui aussi en temps réel, tous deux partageront ainsi des valeurs physiques communes (et forcément complexes). En d'autres termes, FLEX permettra véritablement de toucher du doigt ce que doit être une physique "réaliste" de façon non scriptée.

La vidéo du "FLEX" est à voir en intégralité (5min45) si vous souhaitez bien vous rendre compte de ses possibilités. (à savoir, le partage de valeurs physiques communes au travers de plusieurs objets aux propriétés différentes)

Il va sans dire que les nouveautés introduites par le module "FLEX" sont compatibles avec les dernières technologies implémentées dans PhysX, à l'image de l'algorithme "APEX Turbulence", dont voici deux vidéos :

En conclusion :

Avec le "Gameworks", il parait maintenant évident que Nvidia entend bien assoir son avance sur AMD/ATI durant les prochaines années, tout du moins en ce qui concerne le marché PC (Nvidia étant déjà détenteur de plus de 65% des parts du marché). Il s'agira maintenant de vérifier si les technologies propriétaires du constructeur seront mises à profit au sein d'un plus grand nombre de titres d'envergure.

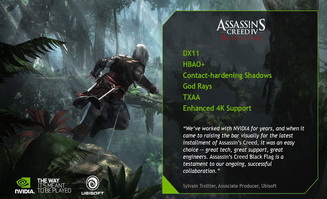

Cela étant dit, on peut se montrer confiant dans la mesure où la firme au caméléon est épaulée par la majorité des plus gros studios de l'industrie et a déjà pris soin d'annoncer une compatibilité de PhysX et d'autres technologies propriétaires au travers de pointures à venir telles que Watch_Dogs, Assassin's Creed IV, The Witcher 3, Project Cars, Star Citizen et d'autres qui ont sans doute échappées à ma vigilance. (en plus d'avoir été présent sur des titres récents tels que Call of duty : Ghost, Batman Arkham Origins ou encore Splinter Cell Blacklist).

En d'autres termes, contrairement à ces dernières années, on ne peut plus reprocher à Nvidia de développer des technologies enthousiasmantes, mais finalement exploitées dans bien peu de jeux. À l'avenir, sur ce point précis, il y a fort à parier que le constructeur aille plus que jamais de l'avant.

Les partenaires actuels de "Gameworks" :

Par ailleurs, au sujet de The Witcher 3 et étant donné que je ne cache pas être un fan de la licence, je vous propose de découvrir ou de redécouvrir une vidéo "off-screen" de certaines technologies Nvidia employées dans ce dernier.

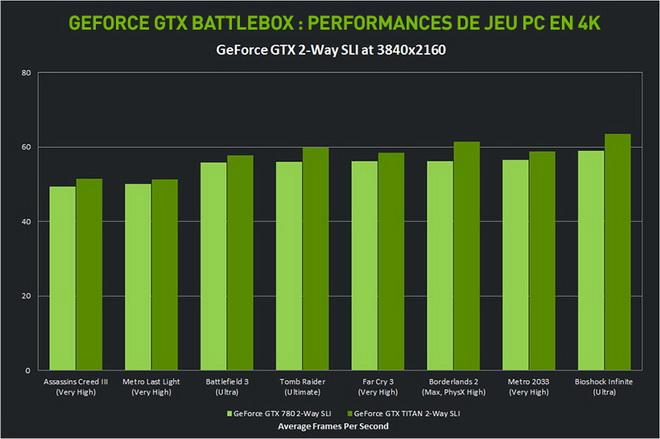

Voilà une partie du dossier qu'on va plier rapidement étant donné qu'elle ne concernera qu'une infime partie de mon lectorat... En effet, Nvidia a récemment créé le label "Battlebox", comme le nom le laisse supposer, il s'agit de configurations gamers hors de prix offrant des performances stratosphériques et permettant donc de jouer en 4K, de faire du multi-écrans à 60 FPS sur des titres extrêmement gourmands, ou encore de profiter du système 3D vision dans des conditions optimales (voire tout cela réuni sur des titres moins exigeants).

Bref, on nage en plein délire/fantasme ! Avec des configurations affichées aux tarifs avoisinant les 3000€, vous aurez évidemment droit au top du top, à la crème de la crème... Mais la vraie question dans tout ça est : "est-ce bien utile ?" Dans la mesure ou des configurations deux fois moins chères permettent déjà de jouer à tous les jeux du marché en 1440p, paramètres poussés au maximum et ce, à 60 FPS, vous imaginez bien que l'intérêt ici est très limité... et comme mon préambule l'annonçait, ne se sentiront probablement concernés que ceux ayant les moyens de se payer une Lambo et l'essence qui va avec. (et accessoirement un téléviseur 4K)

Vous pouvez néanmoins jeter un oeil sur les modèles proposés par LDLC.com, Materiel.net ou encore Absolute PC.fr. Si vous souhaitez en savoir plus, vous pouvez aussi vous rendre sur la page officielle "Battlebox" d'Nvidia.

Jusqu'à présent, la GTX TITAN se présentait comme le fleuron des GPU Nvidia, extrêmement performante et onéreuse puisque dotée d'un tarif flirtant avec les 1000€, cette dernière fut et reste une carte d'abord conçue pour faire briller la marque. Un peu à l'image de la lutte acharnée qui faisait rage entre les USA et l'URSS pour la conquête de l'espace, Nvidia comme AMD/ATI luttent sans cesse pour démontrer leur suprématie en terme de performances... astronomiques.

C'est dans ce contexte de guerre des étoiles que Nvidia décida de lever le voile sur sa 780-Ti, répondant par la même à la tentative d'ATI de prendre la place de leader dans la démesure en dévoilant sa toute nouvelle architecture Hawaï et sa gamme R9. Ainsi, à ma grande déception, et afin de conserver son leadership, Nvidia n'aura donc même pas eu à en faire autant en dévoilant à son tour son architecture MAXWELL. Cette dernière étant toujours "prévue pour vague courant 2014".

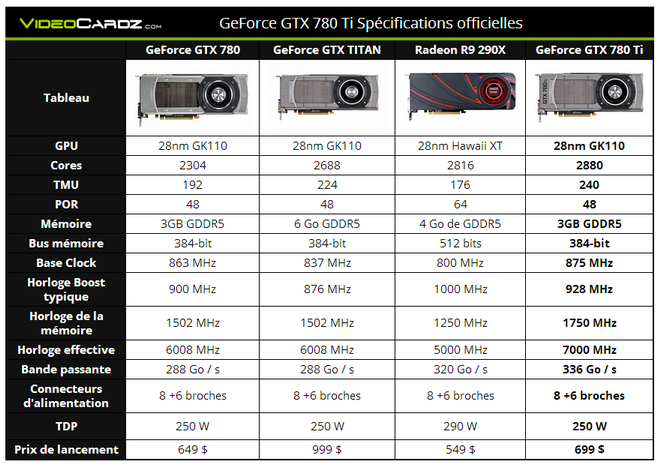

Pour concevoir la 780-Ti, le groupe a ainsi repris les fondamentaux de la TITAN avant de lui retirer ses capacités de calcul "de CUDA à double précision" et ses 6 Go de VRAM, deux éléments qui en faisaient bien plus une carte destinée aux professionnels oeuvrant dans le "GPU Computing", qu'une carte destinée aux gamers. Il a fallu ensuite augmenter les fréquences mémoire (notamment avec une vitesse effective de 7000 MHz !) et permettre à cette dernière d'obtenir une bande passante encore supérieure (336 Go par secondes).

Voici les specs officielles :

Reste l'argument du prix... évidemment. De fait, 649€ c'est effectivement une somme très importante, cela étant dit, il s'agit pour l'heure de la carte la plus véloce au monde, donc forcément il y a un coût lié au privilège d'avoir un tel matériel de pointe (à l'image de n'importe quelle industrie) mais aussi un coût lié au design, sous-entendu, une architecture globale qui sait allier puissance et fiabilité, ainsi qu'un système de refroidissement à la fois efficace et silencieux.

Quant à ceux qui se demanderaient ce qu'il va advenir de la TITAN et de son tiquet d'entrée à 1000€, en comparaison avec une 780-Ti plus puissante pour 350€ de moins, celle-ci va continuer à trouver son public auprès des programmeurs et développeurs en herbe en continuant à se positionner comme une carte professionnelle d'entrée de gamme, puisque comme brièvement mentionné plus haut, cette dernière demeure équipée de spécificités hardwares qui leurs sont dédiées (6Go de VRAM et CUDA double précision, entre autres.)

Enfin, à chacun de définir s'il est utile ou pas d'investir dans un tel monstre de puissance, pour ma part, je reste un fervent utilisateur de SLI (comprenez deux GPU "haut de gamme" plutôt qu'un seul GPU "très haut de gamme"), une alternative qui représente à mes yeux une solution au rapport qualité/prix bien supérieur.

On termine sur une très bonne nouvelle puisque depuis une petite semaine, toutes les cartes haut de gamme de chez Nvidia ont vu leur tarif abaissé de 70 à 100€ ! Ainsi il est possible de se procurer une Geforce 770 aux alentours des 280€ ! Je rappelle que c'est une carte capable de faire tourner Battlefield 4 en 1080p / Ultra et à 60 FPS sans broncher, je le sais bien puisque j'ai monté un PC équipé de cette carte très récemment (pour un client).

Aussi je vous encourage chaudement à regarder les tarifs de la gamme 700. D'autant plus que depuis quelques jours, Nvidia propose des bundles vraiment alléchants puisque sont offerts jusqu'à trois titres AAA pour l'achat d'une carte des gammes 600 ou 700.

- Pour la gamme 600 et modèles 760 : Splinter Cell : Blacklist et Assassin IV

- Pour la gamme 700 à partir des 770 : Batman Arkham Origins, Splinter Cell : Blacklist et Assassin IV

Voilà ! j'ai enfin fini ce nouveau dossier qui m'a pris -à peu près- 120 ans à être rédigé -lui aussi-, je peux donc mourir en paix (une seconde fois). Mon seul regret ? Ne pas avoir pu aborder le Shield et ses fonctionnalités de streaming (notamment), mais n'ayant jamais posé les mains sur cette machine, je ne me voyais pas en mesure de lui consacrer un sujet.

Cela étant dit, si vous avez apprécié le travail, aimez, twittez, Facebookez ! Bref, partagez ! c'est toujours très encourageant. Et bien sûr, n'hésitez pas à me faire part de toutes questions, remarques ou suggestions. Enfin, si le cœur vous en dit, vous pouvez aussi favoriser ce modeste blog.

PS : Un GROS merci à pour son aide à la relecture du dossier. (Aka mon correcteur officiel since 2010)